7 月 13 日消息,麻省理工學院(MIT)團隊提出一種基于視覺的深度學習方法,僅需單個攝像頭即可讓軟體機器人和仿生機器人學習運動與控制。

該技術突破有望大幅降低機器人開發成本,相關成果已于 6 月 25 日發表于《自然》主刊(IT之家附 DOI: 10.1038/s41586-025-09170-0)。

傳統工業機器人雖易于建模控制,但剛性結構難以適應狹小或不平坦地形。軟體及仿生機器人雖具備環境適應優勢,卻通常依賴大量傳感器和定制化空間模型。

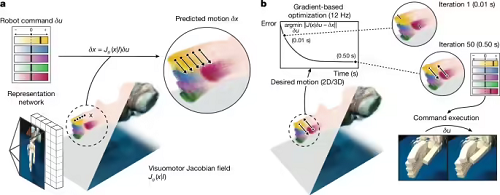

現在,MIT 團隊通過深度學習技術解決了這一矛盾。新系統僅需通過單個攝像頭捕捉機器人運動畫面,結合名為“神經雅可比場(NJF)”的技術,使機器人通過視覺反饋建立對自身形態與運動能力的認知。

研究團隊對多種機器人進行了 2-3 小時多視角隨機運動視頻訓練,成功讓神經網絡通過單幀圖像重建機器人三維形態與運動范圍。

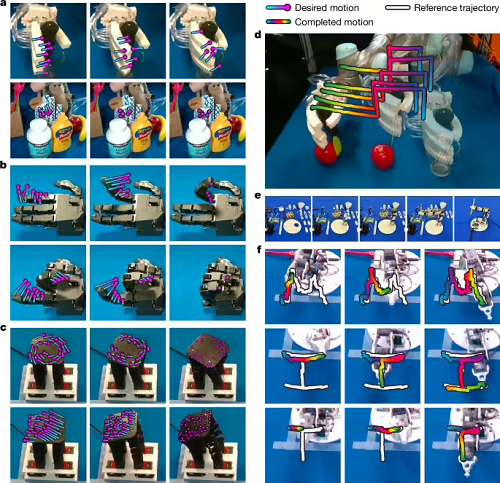

在氣動軟體機械手、奧利格羅機械手(16 自由度)、3D 打印機械臂及低成本 Poppy 機械臂等測試中,系統實現:

關節運動誤差小于 3 度

指尖控制誤差小于 4 毫米

可自適應環境動態變化

MIT 助理教授文森特?西茨曼(Vincent Sitzmann)表示:“視覺作為彈性傳感器,為農場、工地等非結構化環境中的機器人應用開啟新可能。”

CSAIL 主任丹妮拉?羅斯(Daniela Rus)補充道:“視覺反饋使系統建立自身運動動力學內部模型,在傳統定位方法失效處實現自監督操作。”

本站內容除特別聲明的原創文章之外,轉載內容只為傳遞更多信息,并不代表本網站贊同其觀點。轉載的所有的文章、圖片、音/視頻文件等資料的版權歸版權所有權人所有。本站采用的非本站原創文章及圖片等內容無法一一聯系確認版權者。如涉及作品內容、版權和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當措施,避免給雙方造成不必要的經濟損失。聯系電話:010-82306118;郵箱:aet@chinaaet.com。